HP quiere cambiar las reglas de la computación a partir de 2016

Los esfuerzos de Hewlett-Packard de lanzar una arquitectura informática completamente nueva, potencialmente mucho más rápida y simple, pueden empezar a dar fruto para finales de 2016, cuando los laboratorios de la compañía esperan tener la primera máquina prototipo basada en su diseño.

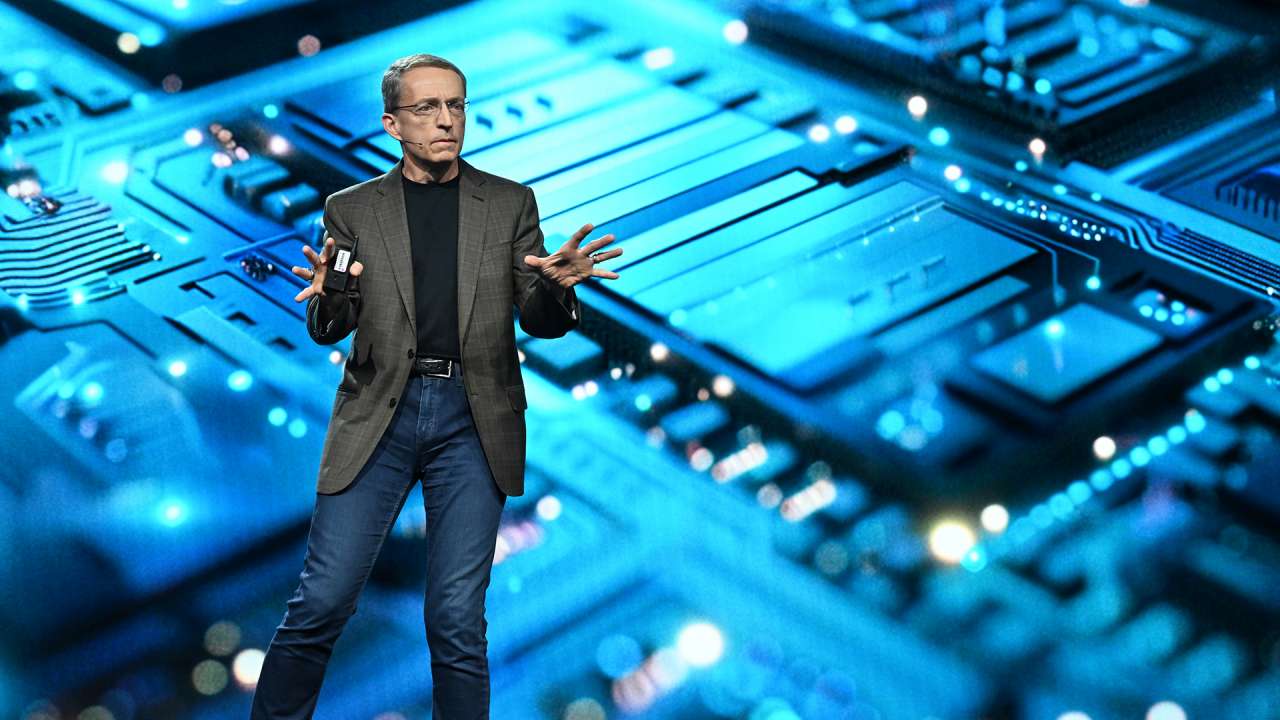

Si la nueva arquitectura de la “Máquina” de HP fuera exitosa, todo el mundo en el negocio de la TI, desde los científicos informáticos a los administradores de sistemas, tendrían que repensar sus trabajos, a juzgar por una charla que el director de los Laboratorios de HP, Martin Fink, dio en la conferencia del 10º aniversario del Software Freedom Law Center, el pasado viernes en Nueva York.

HP desveló por primera vez sus planes para la “Máquina” en su conferencia de usuarios Discover el pasado junio, anticipando que podría ofrecer ordenadores disponibles comercialmente basados en su diseño dentro de 10 años. Fink afirmó que el primer prototipo de la Máquina podría estar operando en 2016, dando a la compañía unos pocos años más para perfeccionarla.

Según Martin Fink, la Máquina reformula la arquitectura informática de Von Neumann que ha dominado desde el nacimiento de la informática, en la que un ordenador tiene un procesador, una memoria de trabajo y almacenamiento. Para poder correr un programa el procesador carga las instrucciones y los datos desde el almacenamiento a la memoria para ejecutar las operaciones, y luego copia los resultados de nuevo en el disco para su almacenamiento permanente si es necesario.

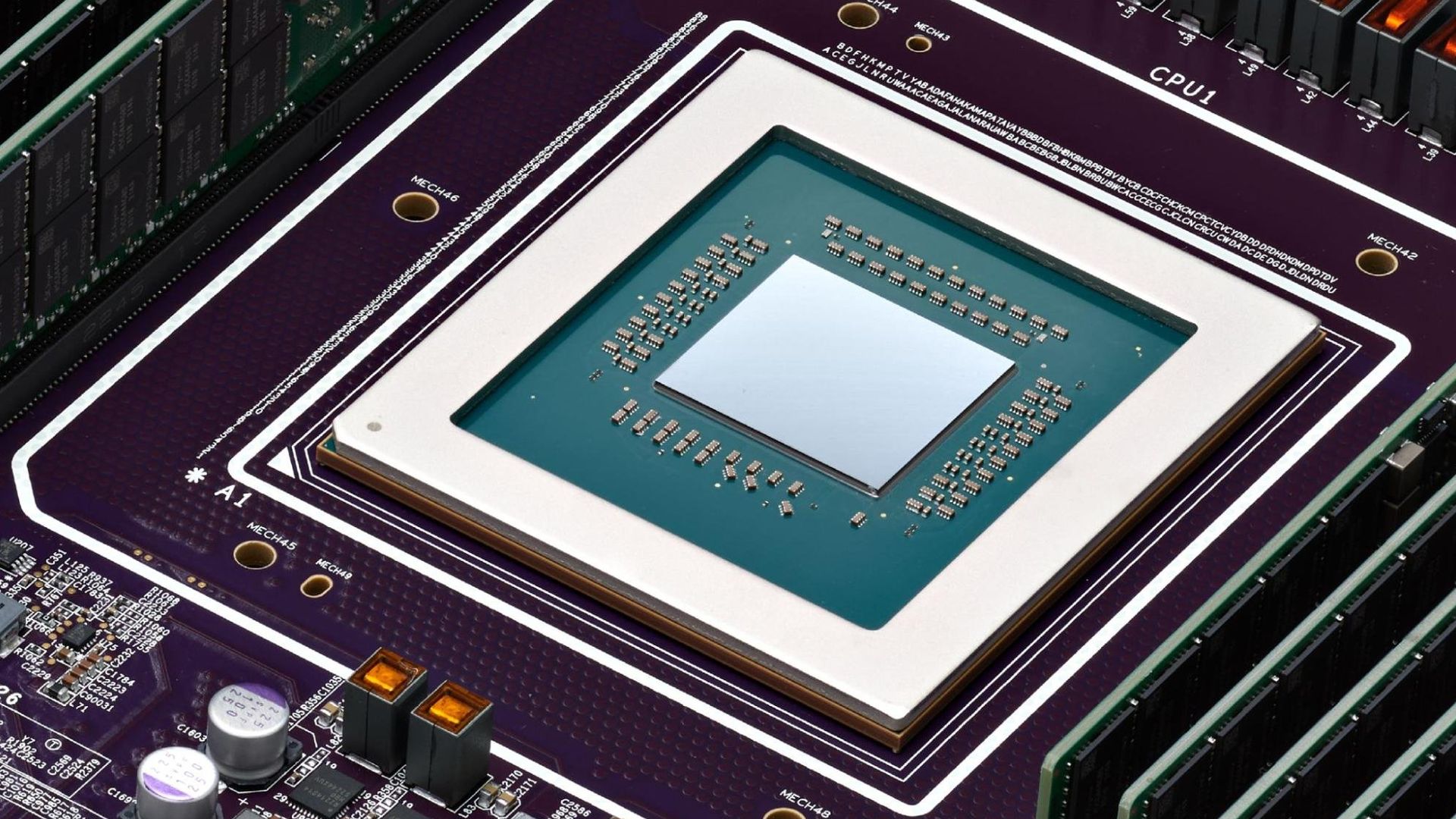

A causa de que las técnicas de fabricación para producir memoria RAM están alcanzando sus límites, la industria tendrá que moverse a otra forma de memoria. Hay un número de diseños experimentales para la memoria de la siguiente generación, y HP está trabajando en su propia versión, llamada “memristor”, en la que se basa la Máquina.

Todos los nuevos diseños de memoria tienen la característica común de ser persistente, de forma que si pierden la alimentación retienen su contenido, no como la RAM actual. En efecto, pueden así reemplazar a los mecanismos de almacenamiento tradicional, como los discos duros o memoria de estado sólido. Esto significa que los ordenadores podrían operar así directamente sobre los datos mismos, en los “memristors” en el caso de HP, en lugar de transportar los datos de ida y vuelta entre la memoria y el almacenamiento.

Un cambio tan simple en la arquitectura tendría no obstante una serie de efectos radicales en casca en cómo funciona la informática, explicó Fink.

Este enfoque significaría que los ordenadores podrían en teoría ser mucho más potentes de lo que son hoy día.

HP afirma que un ordenador del tipo de la Máquina podría tener seis veces las prestaciones y requerir 80 veces menos energía. Fink espera que el primer prototipo en el que está trabajando HP tendría 150 nodos con 157 petabytes de memoria direccionable.

Tal máquina requeriría un sistema operativo totalmente nuevo, afirmó Fink. La mayoría del trabajo que realiza un sistema operativo involucra el copiar datos entre la memoria y el disco. La Máquina eliminaría la noción de escritura y lectura de datos.

Los Laboratorios de HP están trabajando en lo que Fink denomina un sistema operativo “de hoja en blanco”, denominado Carbon. La compañía publicará código abierto ya el próximo año. Está también modificando una versión de Linux denominada tentativamente “Linux++”, para asegurar a los usuarios una transición conveniente desde el estilo de informática Von Neumann.

También las aplicaciones necesitarían ser repensadas en este nuevo estilo informático. En particular las bases de datos relacionales parecerán arcaicas debido a sus elaborados mecanismos de indexado y reenvío de datos a los discos una vez terminada la transacción. En el nuevo diseño “la noción de persistencia secundaria desaparece”, afirma Fink.

En su lugar, las operaciones de base de datos se parecerán más a lo que se conoce como bases de datos gráficas, en las que un programa busca formas de optimizar los datos disponibles para un problema en particular. Fink destacó que Facebook ha desarrollado alguna experiencia en este aspecto, dato que posee y procesa rutinariamente un conjunto de datos de información interrelacionada de sus 1000 millones de usuarios.

En lugar de bases de datos relacionales Hadoop puede ser algo que encaje mejor en esta nueva arquitectura, dado que no necesita imponer ningún orden en los datos mismos, dice Fink.

Otra ventaja que la arquitectura de la Máquina ofrecerá es la simplicidad, según Fink. Hoy el sistema estándar puede tener entre 9 y 11 capas de almacenamiento de datos, desde los caches L1 super-rápidos a los lentos discos duros. Cada capa es un compromiso entre persistencia y rapidez. Esta jerarquía lleva a una enorme complejidad de diseño, que puede eliminarse en su mayoría por el diseño mucho más plano de la utilización de una única memoria, rápida y persistente.

“Nuestro objetivo con la Máquina es eliminar la jerarquía”, afirmó Fink.