Un cerebro para ‘gobernarlos a todos’

Científicos de la UPM desarrollan una interfaz con tecnología de realidad virtual e inteligencia artificial que es capaz de controlar a varios robots a la vez, facilitando así el trabajo de las personas que gestionan estas máquinas en las distintas industrias.

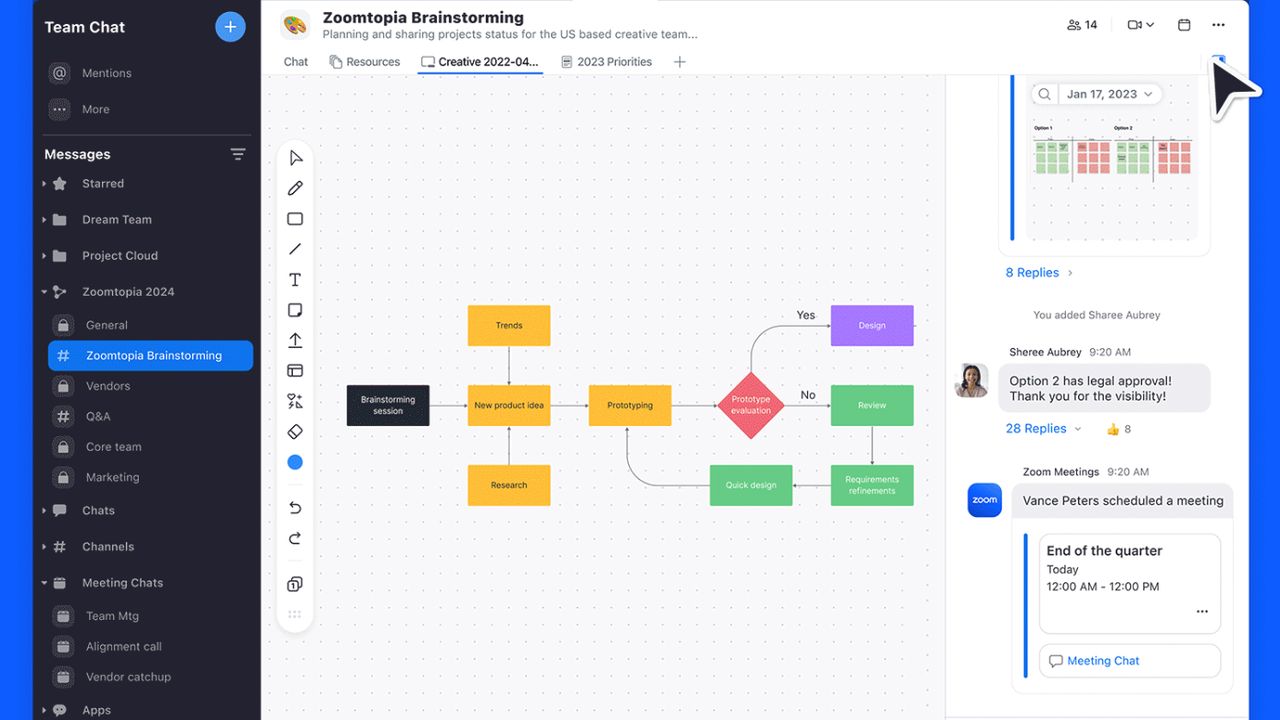

Con el objetivo de mejorar el trabajo de los operadores de robots y hacerlo más productivo, un grupo de investigadores del Grupo de Robótica y Cibernética (RobCib) del Centro de Automática y Robótica (CAR) – un centro mixto de la Universidad Politécnica de Madrid (UPM) y el Consejo Superior de Investigaciones Científicas (CSIC) – ha desarrollado una herramienta basada en realidad virtual y que usa técnicas de aprendizaje automático que permite controlar a varios robots a la vez.

Como explica Juan Jesús Roldán, investigador de RobCib, “actualmente las misiones requieren más operadores que robots: lo más habitual es que haya uno para controlar los movimientos y otro para analizar los datos de cada robot. El objetivo es que, dentro de unos años, un solo operador sea capaz de controlar simultáneamente varios robots”.

En este sentido, desde el Grupo de Robótica y Cibernética recuerdan que cuando se habla de robótica no solo hay que pensar en robots. “Nos imaginamos una flota de drones buscando víctimas tras un desastre natural, un grupo de robots humanoides como guías de museo o un equipo de robots terrestres aplicando tratamientos a cultivos. Es una asociación de lo más habitual y, sin embargo, al hacerla nos olvidamos de los otros grandes protagonistas de la robótica: los operadores”.

Operador de robot, un trabajo complejo

Estos son las personas que planifican las rutas de los robots en el museo, interpretan las imágenes de los drones, organizan el rescate de las víctimas o señalan a los robots las plantas que deben tratar. Un trabajo que, afirman, “no es fácil”, pues hay que gestionar una gran carga de trabajo, consistente en interpretar la información de la misión, tomar decisiones y generar comandos para los robots. Además de mantener una buena consciencia de la situación, lo que significa ser capaz de reconstruir el escenario a partir de los datos obtenidos por los robots, y saber dónde se encuentran y qué están haciendo estos en cada momento.

Con la nueva herramienta estos operadores podrán introducirse en el escenario donde los robots desarrollan la misión y moverse por la escena buscando el mejor lugar para observar y dirigir con precisión a las máquinas para que realicen sus tareas.

Los próximos pasos del trabajo de investigación consistirán en integrar una mayor variedad de escenarios (exteriores e interiores) y robots (terrestres y aéreos) y probar nuevos métodos para que los operadores comanden los robots de forma cómoda e intuitiva. El trabajo se enmarca en el proyecto SAVIER (Situational Awareness VIrtual EnviRonment) de Airbus y en él han estado implicadas la Universidad Politécnica de Madrid, donde se desarrollaron las interfaces, y la Universidad de Luxemburgo, donde se realizaron los experimentos con drones. Los resultados han sido publicados por la revista Sensors.