El MIT consigue hacer comprensibles los componentes para el aprendizaje automático

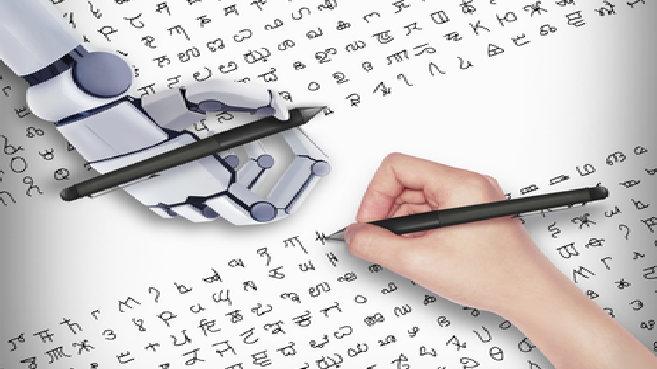

Los investigadores desarrollan herramientas para ayudar a los científicos de datos a hacer que las características utilizadas en los modelos de aprendizaje automático sean más comprensibles para los usuarios finales.

Los métodos de explicación que ayudan a los usuarios a entender y confiar en los modelos de aprendizaje automático suelen describir en qué medida contribuyen a su predicción determinadas características utilizadas en el modelo. Por ejemplo, si un modelo predice el riesgo de que un paciente desarrolle una enfermedad cardíaca, un médico podría querer saber en qué medida los datos de la frecuencia cardíaca del paciente influyen en esa predicción.

Pero si esas características son tan complejas o enrevesadas que el usuario no puede entenderlas, ¿sirve de algo el método de explicación?

Los investigadores del MIT se esfuerzan por mejorar la interpretabilidad de las características para que los responsables de la toma de decisiones se sientan más cómodos utilizando los resultados de los modelos de aprendizaje automático. Basándose en años de trabajo de campo, han desarrollado una taxonomía para ayudar a los desarrolladores a crear características que sean más fáciles de entender para su público objetivo.

"Nos dimos cuenta de que, en el mundo real, a pesar de que utilizamos los métodos más avanzados para explicar los modelos de aprendizaje automático, sigue habiendo mucha confusión derivada de las características, no del modelo en sí", afirma Alexandra Zytek, estudiante de doctorado en ingeniería eléctrica e informática y autora principal de un artículo que presenta la taxonomía.

Para construir la taxonomía, según publica la oficina MIT News, los investigadores definieron las propiedades que hacen que las características sean interpretables para cinco tipos de usuarios, desde los expertos en inteligencia artificial hasta las personas afectadas por la predicción de un modelo de aprendizaje automático. También ofrecen instrucciones sobre cómo los creadores de modelos pueden transformar las características en formatos que sean más fáciles de comprender para los profanos.

Esperan que su trabajo inspire a los creadores de modelos a considerar el uso de características interpretables desde el principio del proceso de desarrollo, en lugar de tratar de trabajar hacia atrás y centrarse en la explicabilidad después del hecho.

Entre los coautores del MIT se encuentran Dongyu Liu, postdoc, la profesora visitante Laure Berti-Équille, directora de investigación en el IRD, y el autor principal Kalyan Veeramachaneni, investigador científico principal del Laboratorio de Sistemas de Información y Decisión (LIDS) y líder del grupo Data to AI. A ellos se une Ignacio Arnaldo, científico principal de datos en Corelight. La investigación se publica en la edición de junio del boletín Explorations, revisado por pares, del Grupo de Interés Especial en Descubrimiento de Conocimiento y Minería de Datos de la Association for Computing Machinery.

Lecciones del mundo real

Las características son variables de entrada que se introducen en los modelos de aprendizaje automático; normalmente se extraen de las columnas de un conjunto de datos. Los científicos de datos suelen seleccionar y elaborar manualmente las características del modelo, y se centran principalmente en garantizar que las características se desarrollen para mejorar la precisión del modelo, no en si un responsable de la toma de decisiones puede entenderlas, según explica Veeramachaneni.

Durante varios años, él y su equipo han trabajado con los responsables de la toma de decisiones para identificar los retos de usabilidad del aprendizaje automático. Estos expertos en cualquier materia, que en su mayoría carecen de conocimientos de aprendizaje automático, no suelen confiar en los modelos porque no entienden las características que influyen en las predicciones.

En un proyecto, colaboraron con médicos de la UCI de un hospital que utilizaron el aprendizaje automático para predecir el riesgo de que un paciente sufriera complicaciones tras una operación cardíaca. Algunas características se presentaron como valores agregados, como la tendencia de la frecuencia cardíaca de un paciente a lo largo del tiempo. Aunque las características codificadas de este modo estaban "preparadas para el modelo" (el modelo podía procesar los datos), los médicos no entendían cómo se calculaban. Preferirían ver cómo se relacionan estas características agregadas con los valores originales, para poder identificar anomalías en la frecuencia cardíaca de un paciente, dice Liu.

En cambio, un grupo de científicos especializados en aprendizaje prefería las características agregadas. En lugar de tener una característica como "número de mensajes que un estudiante hizo en los foros de discusión", preferían tener características relacionadas agrupadas y etiquetadas con términos que entendieran, como "participación".

"Con la interpretabilidad, una talla no sirve para todos. Cuando se pasa de un área a otra, hay diferentes necesidades. Y la propia interpretabilidad tiene muchos niveles", dice Veeramachaneni.

La idea de que una talla no sirve para todo es la clave de la taxonomía de los investigadores. Definen las propiedades que pueden hacer que los rasgos sean más o menos interpretables para los distintos responsables de la toma de decisiones y señalan qué propiedades son probablemente las más importantes para usuarios concretos.

Por ejemplo, los desarrolladores de aprendizaje automático pueden centrarse en tener características que sean compatibles con el modelo y predictivas, lo que significa que se espera que mejoren el rendimiento del modelo.

Por otro lado, los responsables de la toma de decisiones sin experiencia en el aprendizaje automático podrían estar mejor servidos por las características que se describen con palabras humanas, es decir, de una manera que es natural para los usuarios, y comprensible, lo que significa que se refieren a las métricas del mundo real que los usuarios pueden razonar.

"La taxonomía dice que si se crean características interpretables, ¿hasta qué nivel son interpretables? Es posible que no se necesiten todos los niveles, dependiendo del tipo de expertos en la materia con los que se trabaje", afirma Zytek.

Dar prioridad a la interpretabilidad

Los investigadores también describen las técnicas de ingeniería de características que un desarrollador puede emplear para hacer que las características sean más interpretables para un público específico.

La ingeniería de características es un proceso en el que los científicos de datos transforman los datos en un formato que los modelos de aprendizaje automático puedan procesar, utilizando técnicas como la agregación de datos o la normalización de valores. La mayoría de los modelos tampoco pueden procesar datos categóricos a menos que se conviertan en un código numérico. Estas transformaciones suelen ser casi imposibles de descifrar para los profanos.

Crear características interpretables puede implicar deshacer parte de esa codificación, dice Zytek. Por ejemplo, una técnica común de ingeniería de rasgos organiza los intervalos de datos para que todos contengan el mismo número de años. Para que estos rasgos sean más interpretables, se podrían agrupar los rangos de edad utilizando términos humanos, como bebé, niño pequeño, niño y adolescente. O, en lugar de utilizar una característica transformada, como la frecuencia media del pulso, una característica interpretable podría ser simplemente los datos reales de la frecuencia del pulso, añade Liu.

"En muchos ámbitos, la diferencia entre las características interpretables y la precisión del modelo es muy pequeña. Por ejemplo, cuando trabajábamos con los examinadores de bienestar infantil, volvimos a entrenar el modelo utilizando sólo las características que cumplían nuestras definiciones de interpretabilidad, y la disminución del rendimiento fue casi insignificante", dice Zytek.

A partir de este trabajo, los investigadores están desarrollando un sistema que permite a los desarrolladores de modelos manejar transformaciones complicadas de características de una manera más eficiente, para crear explicaciones centradas en el ser humano para los modelos de aprendizaje automático. Este nuevo sistema también convertirá los algoritmos diseñados para explicar conjuntos de datos listos para el modelo en formatos que puedan ser entendidos por los responsables de la toma de decisiones.