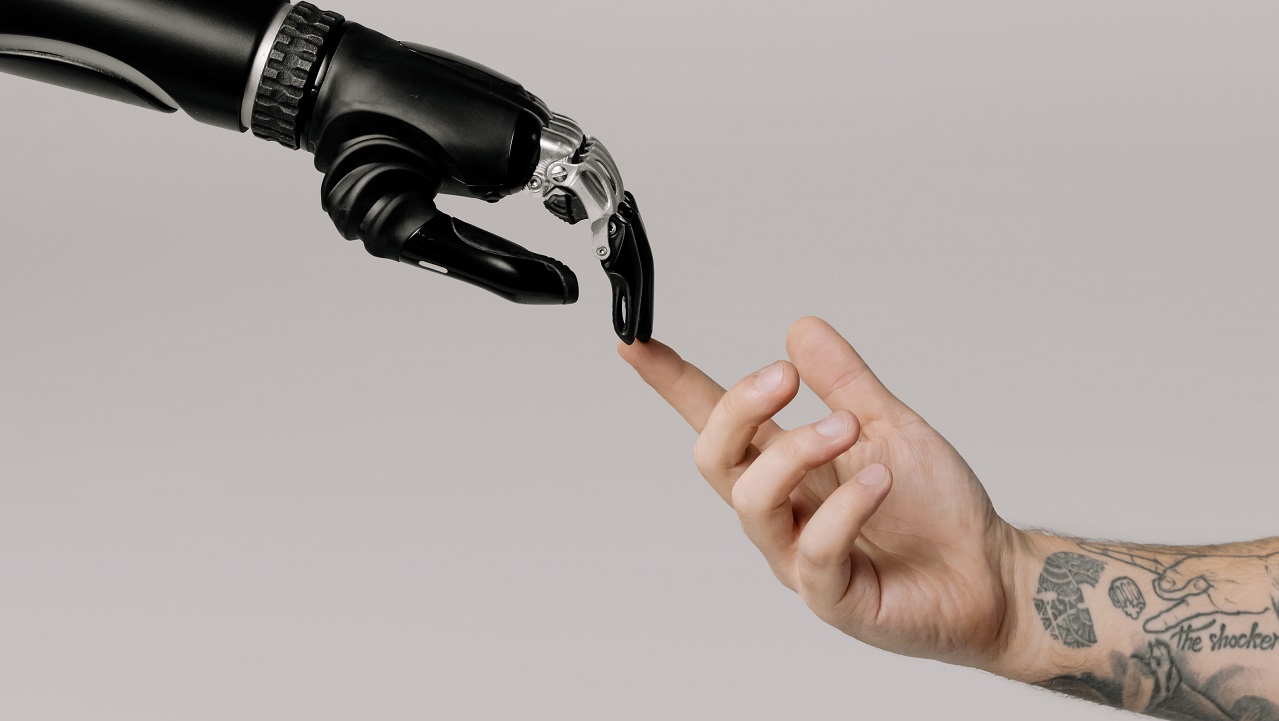

Probando los límites de la inteligencia artificial generativa

Como parte de la curva de aprendizaje con IA y LLM, experimente todo lo que quiera, pero tome los resultados con cierto escepticismo, especialmente si lo está usando para escribir código.

Para aprovechar al máximo las herramientas generativas de inteligencia artificial (IA) como GitHub Copilot o ChatGPT, el fundador de Datasett, Simon Willison, argumenta que debe estar preparado para aceptar cuatro opiniones contradictorias. Es decir, que la IA no es ni nuestra salvación ni nuestra perdición, ni la exageración vacía ni la solución a todo. “No es ninguna de esta y todas al mismo tiempo. Todas son correctas”.

Todo depende de cómo se usen las herramientas y de lo que se espera. Si espera que un asistente de generación de código como AWS CodeWhisperer produzca código perfecto que pueda aceptar y usar al por mayor sin cambios, se sentirá decepcionado. Pero si está utilizando estas soluciones para complementar las habilidades de un desarrollador es posible que se lleve una sorpresa muy positiva.

El problema es que demasiadas empresas espera que ‘lo generativo’ sea una solución mágica para sus problemas. Como destaca el analista de Gartner Stan Aronow, una encuesta reciente pone de relieve que casi el 70% de los líderes empresariales creen que los beneficios superan a los riesgos, a pesar de la comprensión limitada de la aplicabilidad y los riesgos precisos de la IA generativa.

Hablando de modelos de lenguaje grande (LLM, de sus siglas inglesas), Willison argumenta: “Parece que hace tres años, los extraterrestres aparecieron en la Tierran, nos entregaron una memoria USB con esta cosa encendida y luego se fueron. Y desde entonces hemos estado tratando averiguar qué puede hacer”. Sabemos que es importante y podemos sentir algunos de los límites de lo que los LLM pueden hacer, pero todavía estamos en modo de prueba y error.

El problema (y la oportunidad) de los LLM, continúa Willinson, es que “rara vez obtienes lo que realmente pediste”. De ahí el advenimiento de la ingeniería rápida a medida que jugueteamos con formas de lograr que los LLM produzcan más de lo que queremos y menos de lo que no. “Ocasionalmente, alguien descubrirá que si usas este pequeño truco, de repente se abre toda esta nueva vía de habilidades”, señala. Actualmente todos estamos buscando ese “pequeño truco” que lleva a la programación.

Todo en el lugar correcto

Algunos sugieren que los asistentes de codificación serán un gran activo para los desarrolladores no calificados. Eso podría eventualmente ser cierto, pero no a día de hoy. ¿Por qué? No hay forma de confiar adecuadamente en la salida de un LLM sin tener suficiente experiencia para medir sus resultados. Willison cree que “obtener los mejores resultados de ellos en realidad requiere de un montón de conocimiento y experiencia. Mucho de esto se reduce a la intuición”.

Hay hacks de codificación que los desarrolladores descubrirán a través de la experimentación, pero otras áreas simplemente no son una buena opción para GenAI en este momento. Mike Loukides de O'Reilly Media escribe: "No podemos estar tan atados a la generación automática de código que nos olvidemos de controlar la complejidad". Los humanos, aunque imperfectos para limitar la complejidad en su código, están mejor posicionados para hacerlo que las máquinas. Por ejemplo, un desarrollador realmente no puede solicitar a un LLM que reduzca la complejidad de su código porque no está claro qué significaría. ¿Reducir las líneas de código? "Minimizar las líneas de código a veces conduce a la simplicidad, pero con la misma frecuencia conduce a encantamientos complejos que empaquetan múltiples ideas en la misma línea, a menudo confiando en efectos secundarios no documentados", dice Loukides. A las computadoras no les importa la complejidad del código, pero los humanos que necesitarán depurarlo y entenderlo años más tarde sí lo hacen.

Todo esto está bien. Estamos increíblemente temprano en la evolución de la IA, a pesar del hecho de que ha existido durante décadas. A nosotros en tecnología nos gusta adelantarnos. Actuamos como si la nube fuera una norma establecida cuando todavía es solo el 10% más o menos de todo el gasto de TI. A pesar de la avalancha de inversión en IA, ni siquiera es 0,1%.

Para Willison, ahora es el momento de probar los diferentes LLM y sus herramientas de codificación asociadas. Nuestro objetivo no debe ser ver cuál hará todo nuestro trabajo por nosotros, sino descubrir sus fortalezas y debilidades y sondearlos e impulsarlos hasta que sepamos cómo usar sus fortalezas y sus fracasos para nuestro beneficio.