Así es la ‘Constitución’ de Google para los robots con inteligencia artificial

La división de Robótica de DeepMind ha definido una serie de artículos para dar indicaciones seguras a los robots basándose en las Tres leyes de la robótica de Isaac Asimov. Esto es lo que dice el manual.

- Sobre la roboética: “Se debe prestar mucha atención a la diversidad de personas con las que se va a tratar”

- Los robots Atlas ya pueden recoger objetos, transportarlos y lanzarlos

- El Hospital universitario La Paz incorpora un brazo robótico para operaciones de columna

- La robótica autónoma optimiza la inspección de subestaciones eléctricas

- Robótica inteligente y autónoma para explorar y mapear en 3D la superficie lunar

Con el avance irrefrenable de los modelos y herramientas de inteligencia artificial (IA) emergieron una serie de peligros asociados al uso de la tecnología. Expertos, tecnólogos y sector público convinieron definir un paquete de normas y reglas que garantizasen un desarrollo y uso seguro, ético y transparente. Entonces, la Unión Europea tomó el timón y pactó de manera pionera una Ley de Inteligencia Artificial que permite o limita el uso de la tecnología en función del riesgo que implique para las personas mediante una especie de semáforo de colores. Sin embargo, más allá de la normativa pública, proveedores de tecnología como Google han tomado cartas en el asunto con el propósito de controlar los dispositivos basados en IA.

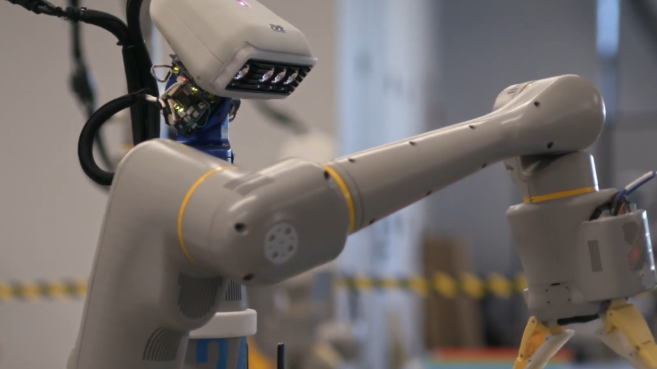

En el caso de la tecnológica natal de Silicon Valley, a través de la división de Robótica de su filial DeepMind, ha elaborado una ‘Constitución’ inspirada en las tres leyes de la robótica que Isaac Asimov plasmó en su tomo Círculo vicioso. La primera ley se asegura de que ningún robot haga daño a ningún ser humano ni, por inacción, permitirá que un ser humano sufra daño; la segunda ley hace referencia a la obligación por parte del robot de cumplir las órdenes dadas por los seres humanos, a excepción de aquellas que entren en conflicto con la primera ley; por último, la tercera ley conlleva que el robot proteja su propia existencia en la medida en que esta protección no entre en conflicto con las normas anteriores.

Tomando estos preceptos como punto de partida, DeepMind ha definido un código de conducta para dar "indicaciones centradas en la seguridad" al robot que tienen como fin evitar tareas que involucren situaciones potencialmente peligrosas. Asimismo, para garantizar una mayor seguridad, DeepMind programó a los robots para que se detengan automáticamente si la fuerza en sus articulaciones supera cierto umbral, e incluyó un interruptor de apagado físico que los operadores humanos pueden usar para desactivarlos.

La compañía usó las citadas directrices en una flota de hasta 53 robots repartidos en cuatro edificios de oficinas distintas, llevando a cabo más de 77.000 pruebas con más de 6.650 tareas únicas.